Das Streiflicht 2019 fand am 29.04.2019 statt.

Was ist das Streiflicht?

Beim Streiflicht präsentieren Studenten aus den Informatikstudiengängen ((Medien-)Informatik, Software Engineering, Cognitive Systems) die Highlights aus den Projekten, Anwendungsfächern und Abschlussarbeiten des vergangenen Jahres. Die Projekte aus verschiedensten Bereichen geben einen hervorragenden Einblick in die Themenvielfalt des Studiums.

Das Streiflicht ist deshalb nicht nur für Studierende der höheren Semester interessant, sondern richtet sich auch vor allem an Studienanfänger und -interessierte. Professoren, Mitarbeiter und sonstige Interessierte auch außerhalb der Informatik sind ebenfalls herzlich eingeladen mit dabei zu sein.

Agenda

17:00 - 17:30 Doors Open

17:30 - 20:00 Präsentationen & Awardvergabe

20:00 - 22.00 Demos & Get-together

22:00 Closing

Präsentationen:

1. Studio 3

2. A Character Like You

3. BOTani (Plant-based Digital Voice Assistant)

4. Publikationsvisualisierung zur interaktiven Analyse von Trends

5. Cheating in Computer Games

6. OrbisOstium

7. Trajektorienplanung für Quadcopter

8. SysOCR

9. Stolperpfade

10. Team Spatzenhirn

11. Compilerbau

12. LMAO Leap Motion Audio Operator

13. Visual-Novel

Raumplan (Demos):

O28/2001

- Studio 3

- A Character Like You

- BOTani

- Cheating in Computer Games

O28/2002

- OrbisOstium

- selfcVRe

- Trajektorienplanung für Quadcopter

- SysOCR

O28/2003

- Stolperpfade

- Arcade Helicopter

- Team Spatzenhirn

- Compilerbau

O28/2004

- Visual-Novel

- EyecareVR

- LMAO

Projekte

A Character Like You (Talk / Demo)

Wenn sich ein Spieler mit seiner virtuellen Repräsentation – seinem Avatar – identifiziert, hat dies unter anderem Einfluss auf seine Freude und Motivation beim Spielen. Im Rahmen einer Masterarbeit, wurde deshalb das Konzept eines Virutal Reality (VR) Spiels entwickelt, welches eben jene Indentifikation erhöhen soll. Die physikalische Aktivität des Spielers wird hierbei über den Tag hinweg beobachtet und auf Mechaniken im Spiel übertragen. Dadurch wird das Gameplay Erlebnis auf den Tag des Nutzers zugeschnitten, Spieler und Avatar werden aneinander angenähert. Gestützt durch eine Vielzahl an größeren und kleineren Playtests wurde das Konzept im Anschluss implementiert und in einer ersten Studie über die Dauer von zwei Wochen getestet.

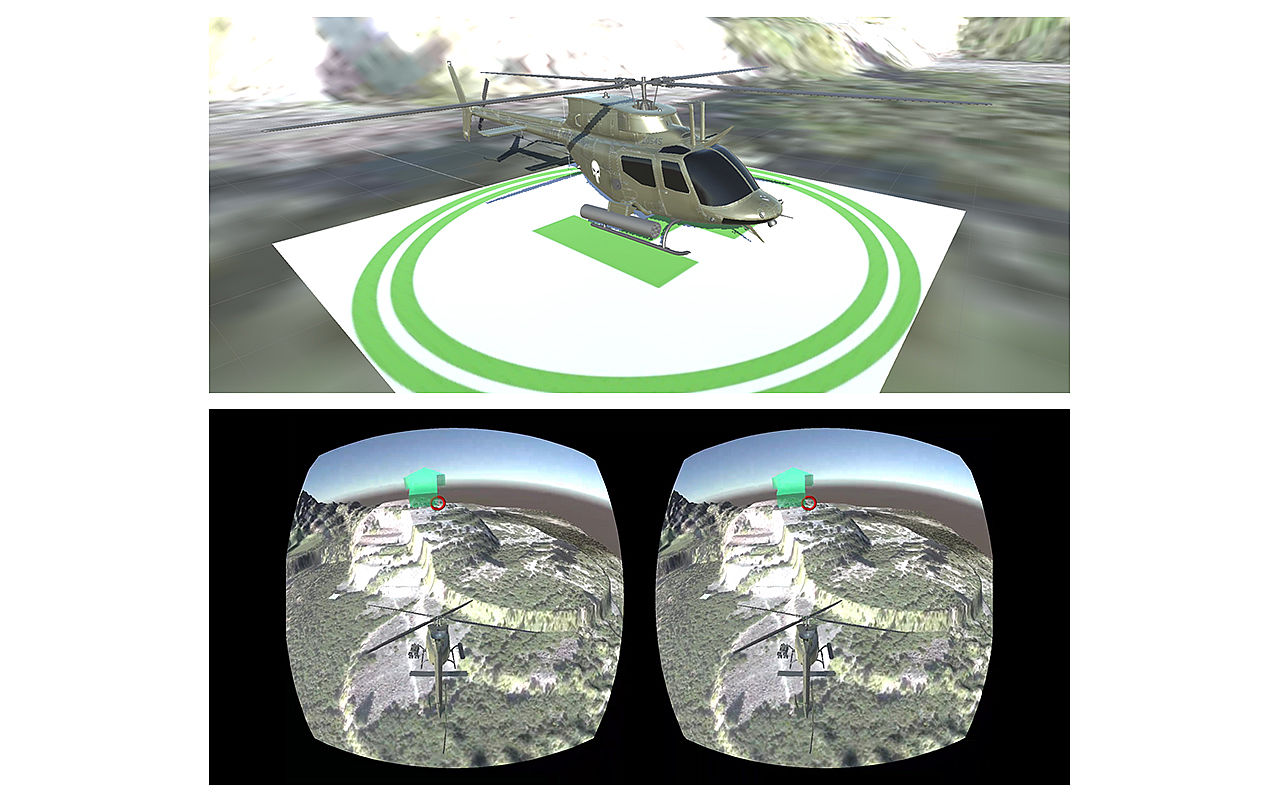

Arcade Helicopter (Demo)

„'Arcade Helicopter' ist eine Virtual Reality (VR) Anwendung, die im Rahmen der Vorlesung und Übung zu 'Mobile Mensch Maschine Interaktion' entstanden ist. Ziel war es, binnen eines Semesters, ein 'Nomadic VR' taugliches Spielkonzept zu entwerfen und für die Oculus Go, eine portable und Geräteunabhängige VR Brille, zu implementieren. Nomadic VR beschreibt dabei das kurzzeitige Erleben von VR in alltäglichen Situation 'on the go'.

Die Anwendung 'Arcade Helicopter' wurde als Geschicklichkeit-orientiertes Spiel zum kurzfristigen und unterhaltsamen Zeitvertreib konzipiert. Die Herausforderung für den Spieler ist es dabei, den Helikopter durch eine virtuelle Gebirgslandschaft zu navigieren, um mit ihm ausgeschriebene Checkpoints zu erreichen und einzusammeln, ohne dabei abzustürzen. In der Tat ist dazu, insbesondere bei Anfängern, ein hohes Maß an Geschicklichkeit erforderlich, um die Checkpoints nicht zu verfehlen. Um gute Endzeiten zu erreichen muss feinfühlig vorgegangen werden, was das Spiel zu einer interessanten Abwechslung im Alltag macht.

BOTani - Plant-based Digital Voice Assistant (Talk / Demo)

BOTani stellt eine symbiotische Verbindung zwischen aktuellen DVA (Digital Voice Assistants) wie Alexa oder Google Assistant und einer gewöhnlichen Zimmerpflanze dar. Der verwendete Sprachassistent, Mycroft, erlaubt durch Open Source Lizenz eine Anpassung, sodass die Pflanze über den Sprachassistenten mit dem Nutzer kommunizieren kann. Dabei können Bedürfnisse geäußert werden im Bezug auf Wasser, Temperatur oder Licht, sowie Informationen über die Pflanze selbst, wann zuletzt gegossen wurde, o.Ä. über Sprachausgabe zur Verfügung gestellt werden. Die Pflanze reagiert hierbei auf ein klassisches Wakeword oder auf Berührung mit einer kleinen Bewegung; der aktuelle Zustand wird noch durch indirekte LEDs mitbetont. Das Setup besteht aus einer Pflanze, Barometer, Thermometer, Lichtsensor, Feuchtigkeitssensor, Berührungssensor, einem kleinen Servomotor und einem Arduino sowie einem Raspberry 3b+ auf dem das System läuft.

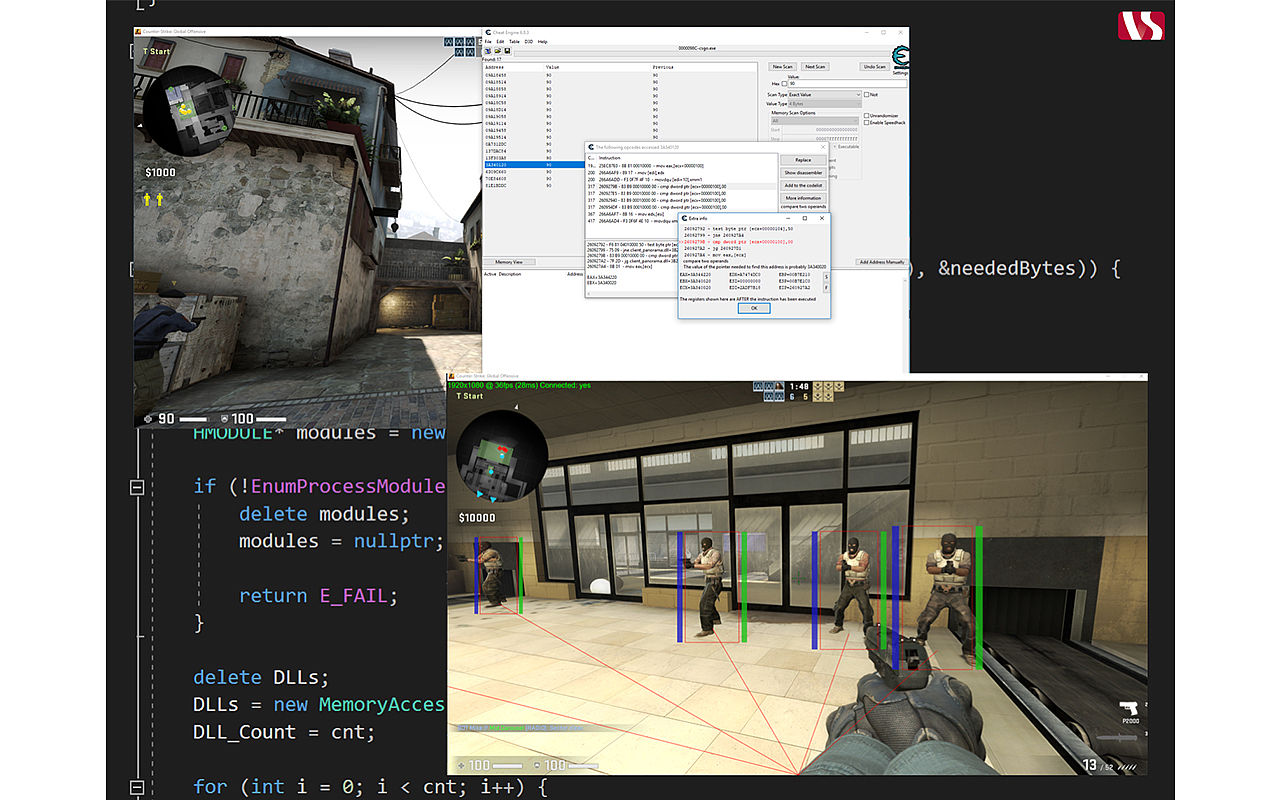

Cheating in Computer Games (Talk / Demo)

Wie angreifbar sind moderne online "First Person Shooter"? Dieser Frage wurde im Rahmen des Bachelor Seminars des Instituts für Verteilte Systeme auf den Grund gegangen. Als Beispiel diente eines der bekanntesten Vertreter des Genres - "Counter-Strike: Global Offensive. Im Fokus standen dabei die Erklärung der Grundkonzepte von Cheats und deren Gegenmaßnahmen sowie die konkrete Implementierung eines funktionsfähigen Cheatprogramms.

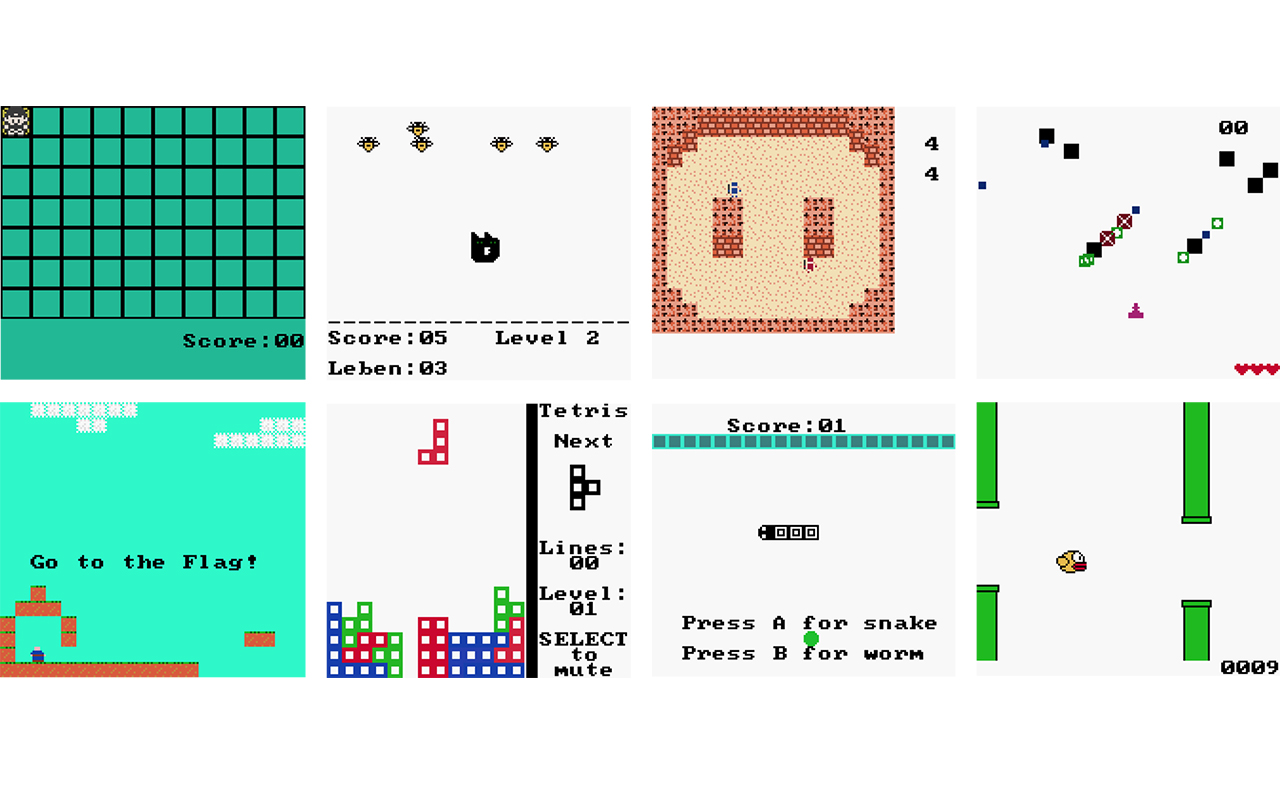

Compilerbau (Talk / Demo)

Im Projekt Compilerbau entwickeln Studenten eigene Programmiersprachen und implementieren dafür einen Compiler, mit dem sich Spiele für den Gameboy COLOR in der eigenen Sprache programmieren lassen. Da der Compiler modular aufgebaut ist, kann in der ersten Phase jeder Student seine eigene Programmiersprache als austauschbares Compiler-Frontend implementieren. Im nächsten Schritt arbeiten die Studenten gemeinsam an Code-Generierung und Optimierung wobei die Qualität durch automatische Integration-Tests sichergestellt wird. Am Ende des Projekts wird der Compiler benutzt, um ein funktionierendes Game Boy Color Spiel in der eigenen Sprache zu schreiben.

EyeCareVR (Demo)

EyeCareVR ist eine nomadische Virtual Reality Anwendung für die Oculus Go welche fünf verschiedenen Übungen zum Trainieren der Augenmuskeln bereitstellt. Dabei müssen Objekte verfolgt, Punkte fokussiert und sich im Raum umgeschaut werden. Alle Aufgaben dienen dazu, den Augenmuskel zu bewegen und den Fokus der Augen zu optimieren. Dies soll dazu dienen, Augenmüdigkeit zu bekämpfen, welche unter anderem auftritt, wenn lange vor einem Bildschirm gesessen wird ohne dass der Fokus der Augen verändert wird.

LMAO - Leap Motion Audio Operator (Talk / Demo)

LMAO (Leap Motion Audio Operator) ist eine Musiksoftware, bei dem man sich in einem virtuellen Musikstudio befindet und Musik kreiert. Positionsparameter der Hände werden dabei durch einen Leap Motion 3D Controller erfasst und dienen als Grundlage zur Steuerung der Software. Die Studioumgebung wird auf einem VR Headset dargestellt und ist mit der Unity Engine realisiert. Diese Kombination ermöglicht es, mit den eigenen Händen zu spielen und steigert die Immersion und auch den Spaß beim Bedienen. Der Benutzer kann in diesem „Sand Box“ Studio unterschiedliche Tools nutzen, um Musik zu spielen, zu verändern und aufzunehmen. In LMAO gibt es vier verschiedene Räume, in denen man sich austoben kann. Jeder Raum kommt mit einer eigenen Musikrichtung, sodass sich sowohl Hiphop- als auch Schlagerfans zuhause fühlen. Ebenso gibt es vier Musiktools: Das Keyboard ist das Melodieinstrument in jedem Raum und kann über Tasten gespielt werden. Der Drum Computer dient als Rhythmusinstrument. Über die Loopstation lassen sich verschiedene Klänge und Beats dazuschalten und das Ganze kann dann mit einem virtuellen Mischpult eingestellt und mit Effekten versehen werden. Über ein Menü direkt an der Hand lässt sich ein Metronom aktivieren und die Aufnahmefunktion steuern. www.youtube.com/watch;

OrbisOstium (Talk / Demo)

Der multimediale Beitrag dieses Projektes dreht sich um das Thema „Menschenrechte“ und ist in Kooperation mit der Ulmer Ortsgruppe von Amnesty International entstanden. Sie soll das Potential des Systems verdeutlichen, welches sich aber auch für beliebige anderen Themenfelder adaptieren lässt. In der Umsetzung wurde eine Weltkarte mit einer Kodierung versehen. Das System zeigt je nach Position auf der Karte die „digitale Version“ der Weltkarte an, in welcher die Möglichkeit besteht auf die einzelnen Länder zu klicken und sich Keyfacts und Informationen aus dem Amnesty International Report zur weltweiten Lage der Menschenrechte anzeigen zu lassen. Um den multimedialen Charakter des Systems zu verdeutlichen, wurden in Kooperation mit den Mitgliedern kurze Clips zu betroffenen Einzelschicksalen gedreht und im System eingebunden, sowie externes Multimedia-Material recherchiert, welches ebenfalls im System abrufbar ist.

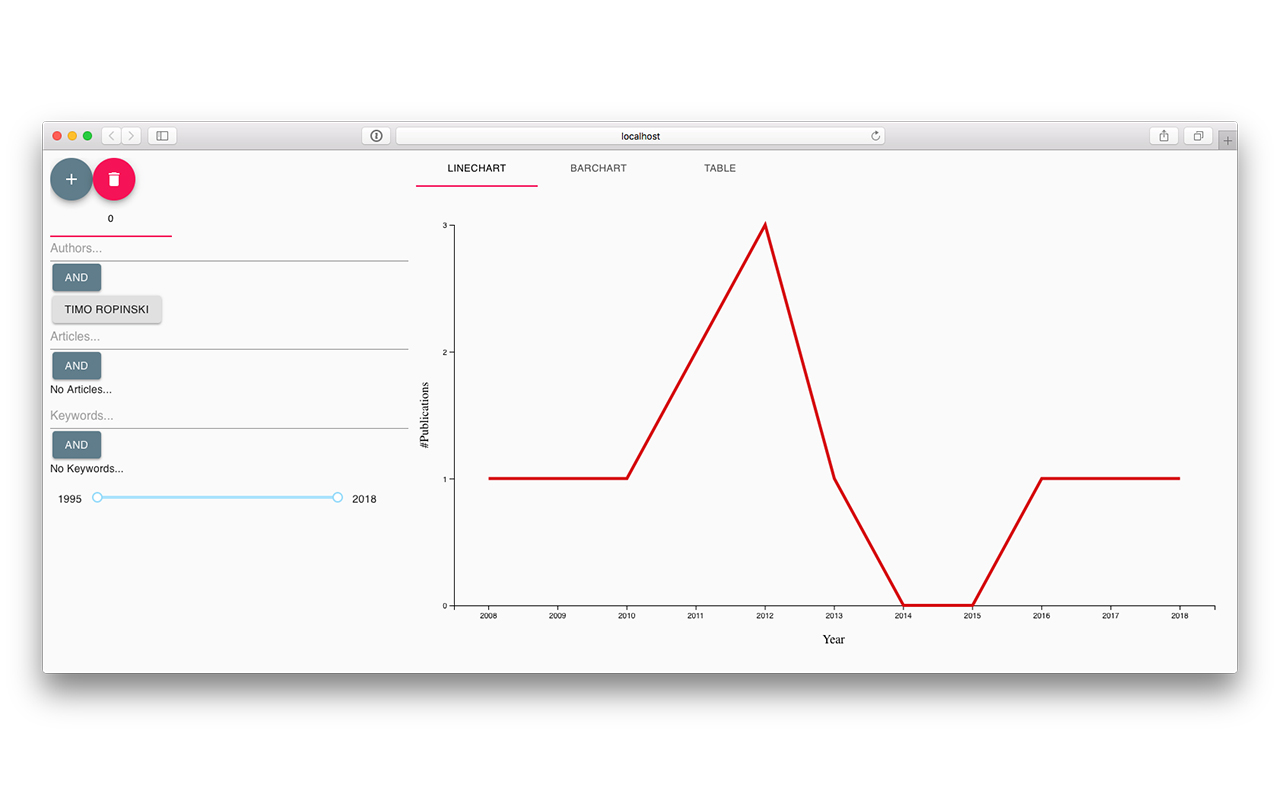

Publikationsvisualisierung zur interaktiven Analyse von Trends (Talk)

Die Analyse der Metadaten wissenschaftlicher Publikationen erlaubt einen spannenden Einblick in die Entwicklungen der Forschung. Sie ermöglichen beispielsweise die interaktive Analysen welche Themenbereiche aktuell im Trend sind und welche Autorinnen und Autoren in diesem Bereich am meisten publizieren. So lassen sich unter anderem Autoren finden die schon in der Vergangenheit ein gutes Gespür für neue Trends hatten oder vor langer Zeit Publikationen verfasst haben, die erst später Beachtung fanden und damit ihrer Zeit voraus waren. Umgesetzt würde die Visualisierung als Webanwendung unter Verwendung der Bibliothek D3.js, um diese für jeden einfach zugänglich zu machen.

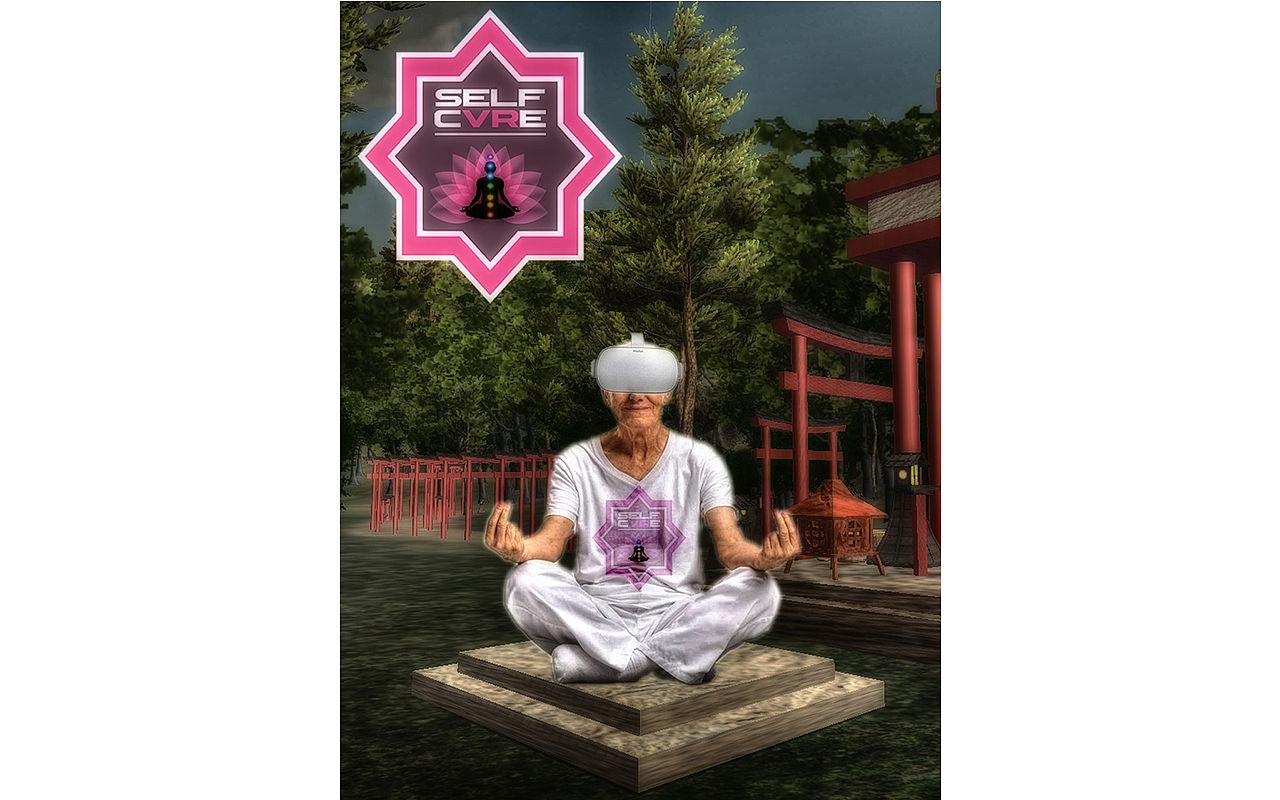

selfcVRe (Demo)

selfcVRe bietet prüfungsgestressten Studenten und Dozenten die Möglichkeit, kurze Meditationseinheiten ohne Vorbereitung und on-the-go in ihren regulärenTagesablauf einzubauen. Dass es sich beim Meditieren nur um eine längst überholte Praktik handelt,die unter Esoterikern verbreitet ist und am besten durchgeführt wird während der Ayurveda-Tee serviert und der Energiekristall gerieben wird, haben Studien widerlegt, deren Fokus auf der Auswirkung von Meditation auf mentale und psychische Gesundheit lag. Ausgehend von diesen Studien haben wir uns entschieden, eine Anwendung zu entwerfen,die aus den Eigenschaften eines standalone VR Headsets einen positiven Nutzenzieht und sich leicht und quasi überall anwenden lässt. Benutzer der App haben die Möglichkeit, eine von mehreren einsteigerfreundlichen Kurzmeditationseinheiten in einer virtuellen Welt durchzuführen, während sie von einem Audio-Guide angewiesen und in die Praktik und den Nutzen des Meditierens eingeführt werden. selfcVRe bietet dem Anwender ein weitgehend immersives Erlebnis aus Bild und Ton, was in einer Nutzerstudie ausführlich getestet wurde.

Spatzenhirn (Talk / Demo)

Unterstützt durch das Institut für Mess-, Regel- und Mikrotechnik der Fakultät für Ingenieurwissenschaften, Informatik und Psychologie der Universität Ulm arbeiten wir jedes Jahr darauf hin am Carolo Cup teilzunehmen. Ziel ist es, bis zum jährlichen Wettbewerb im Februar in Braunschweig ein 1:10 Modellfahrzeug zu entwickeln, welches einen Hindernis-Parcours autonom bestreiten kann. Zugelassen sind nur rein studentische Teams die in kompletter Eigenverantwortung arbeiten.

Stolperpfade (Talk / Demo)

Wenn man aufmerksam durch Ulm läuft, bemerkt man vor manchen Häusern goldfarbene Pflastersteine mit der Aufschrift „Hier wohnte … “. Diese Steine sind Stolpersteine und gehören zu dem größten dezentralen Mahnmal der Welt. Der Künstler Gunter Demnig begann das Projekt 1992, um an die Menschen zu erinnern, die unter Hitlers Gewaltherrschaft verfolgt, deportiert oder ermordet wurden. Mittlerweile gibt es über 70.000 Stolpersteine, die in Deutschland und weiteren 23 europäischen Ländern vor den letzten Wohnsitzen der Opfer verlegt wurden. Leider findet man auf den Stolpersteinen nur wenige Informationen über die einzelnen Schicksale und es ist schwer, in deren Umgebung so etwas ähnliches wie Hinweistafeln aufzustellen. Unser Projekt „Stolperpfad“ soll hierfür eine Lösung bieten: Die Daten der Ulmer Stolpersteine werden in einer Android-App gespeichert und interaktiv dargestellt, sodass sie nach dem Herunterladen von überall aus abgerufen werden können.

Studio 3 (Talk / Demo)

Studio 3 ist eine interaktive Lernanwendung mit Geschichte. Die Anwendung soll dem Nutzer Grundlagen der Spiegelreflex Fotografie näher bringen soll. Der Nutzer betritt, sobald er sich eingeloggt, und somit authentifiziert hat, ein virtuelles Studio. Dieses Studio wird durch ein 360° Foto dargestellt. Das virtuelle Studio wird in unterschiedliche Lernbereiche gegliedert, welche vom Nutzer erkundet werden können. Somit fungiert das Studio als eine Art Hauptmenü der Anwendung. Bei Interesse, kann der Nutzer die Lernbereiche betreten, und näher betrachten – nun in einer schwenkbaren 2D-Ebene.

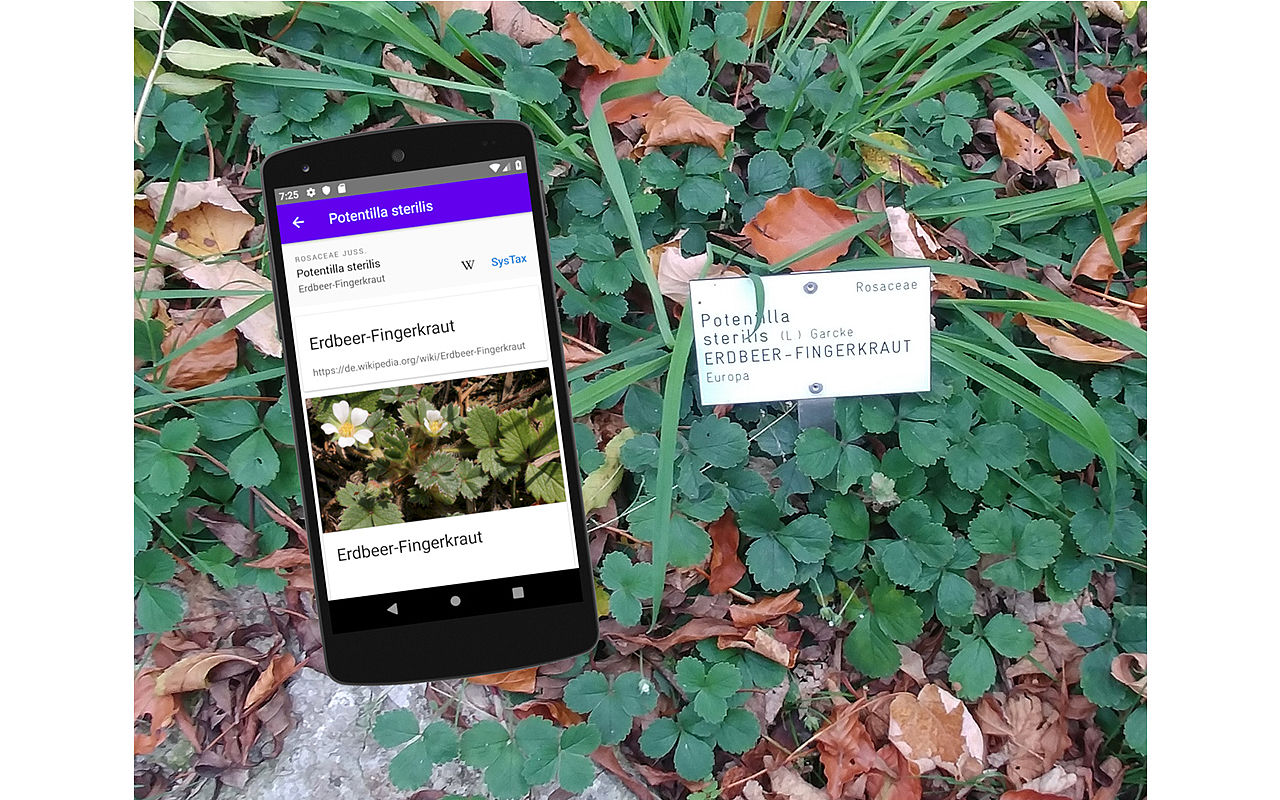

SysOCR (Talk / Demo)

Jeder botanische Garten ist für die elektronische Verwaltung der Daten selber zuständig. Dadurch sind Informationen zu den Pflanzen eines botanischen Gartens schlecht erreichbar. Das Ziel der SysOCR App ist es einfacher an Pflanzeninformationen heranzukommen. Sodass man nicht vor dem Pflanzenschild steht und nach der Pflanze googeln muss. Mit der App kann man die in botanischen Gärten üblichen Oflanzenschilder scannen und erhält Informationen zu der Pflanze vor der man steht. Es gibt zwar eine zentrale Datenbank für Pflanzeninformationen (systax.org). Viele botanische Gärten sind aber sehr stur und stellen ihre Pflanzeninformationen nicht freiwillig zur Verfügung. Die App versucht diese Daten selbst zu sammeln, indem Zusatzinformationen (z.B. QR-Codes and Ort) von den gescannten Pflanzenschilder gespeichert werden. Dadurch soll die zentrale Datenbank mit mehr Geo- und Mediendaten gefüllt werden, die Botanikern und den Nutzern der App zur Verfügung stehen.

Trajektorienplanung für Quadcopter (Talk / Demo)

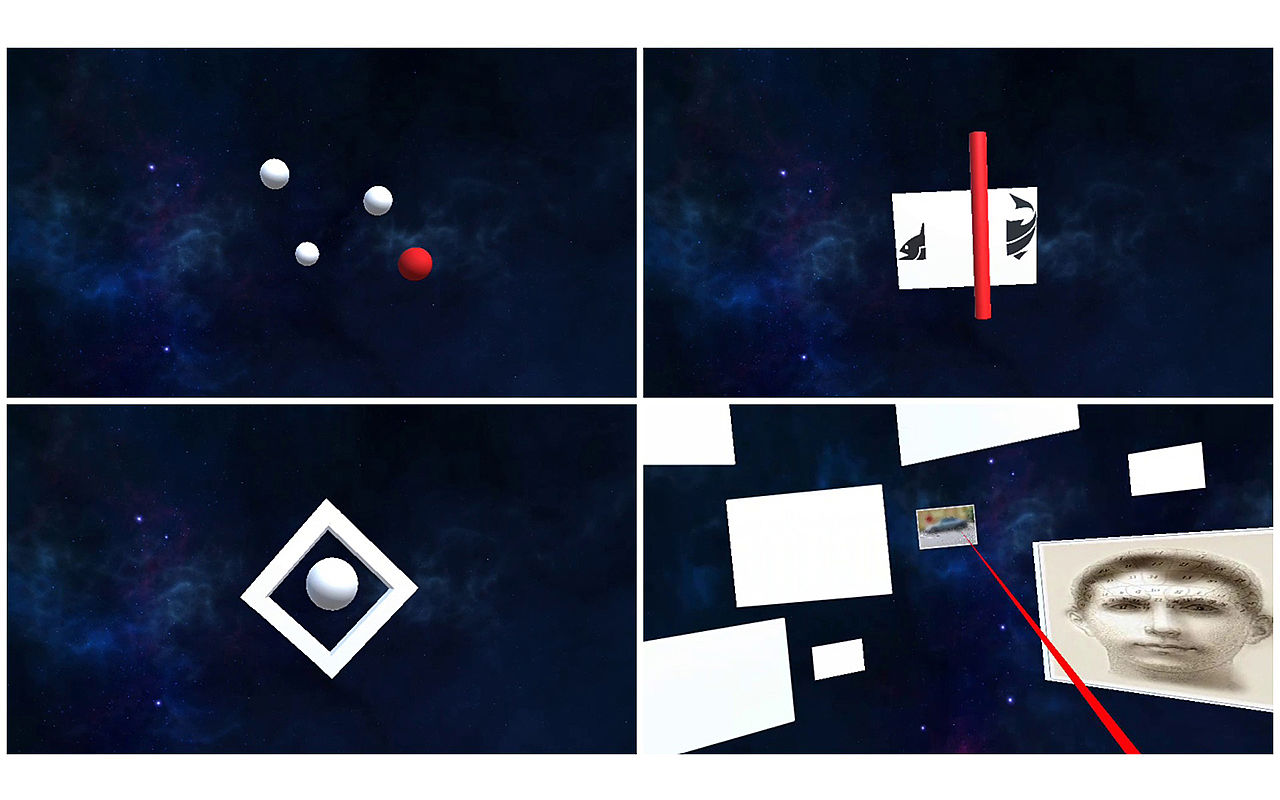

Um einen Quadcopter von einem Punkt zu einem anderen fliegen zu lassen, benötigt es einen Pfad im Raum. Einen solchen Pfad bezeichnet man als Trajektorie. Bei der Planung einer Trajektorie müssen viele Faktoren berücksichtigt werden. Unter anderem muss berücksichtigt werden, welche Hindernisse im Raum stehen, wie sich die anderen Quadcopter verhalten und jeweils die Maximalgeschwindigkeiten und -beschleunigungen aller Quadcopter. Ziel unseres Projektes ist es, die bisherige Trajektorienplanung inklusive derer Hindernisvermeidung zu verbessern und in unserem Labor praktisch umzusetzen. Dort lässt sich dank unseres objekterkennenden Kamerasystems ein dreidimensionales Umgebungsmodell erstellen, worin wir die Trajektorien der Quadcopter planen. Diese werden dann von unseren sieben Quadcoptern nachgeflogen. Zusätzlich sollte ein weiteres Quadcoptermodell angesteuert werden. Dazu war die Implementierung einer entsprechenden Treiberkomponente nötig.

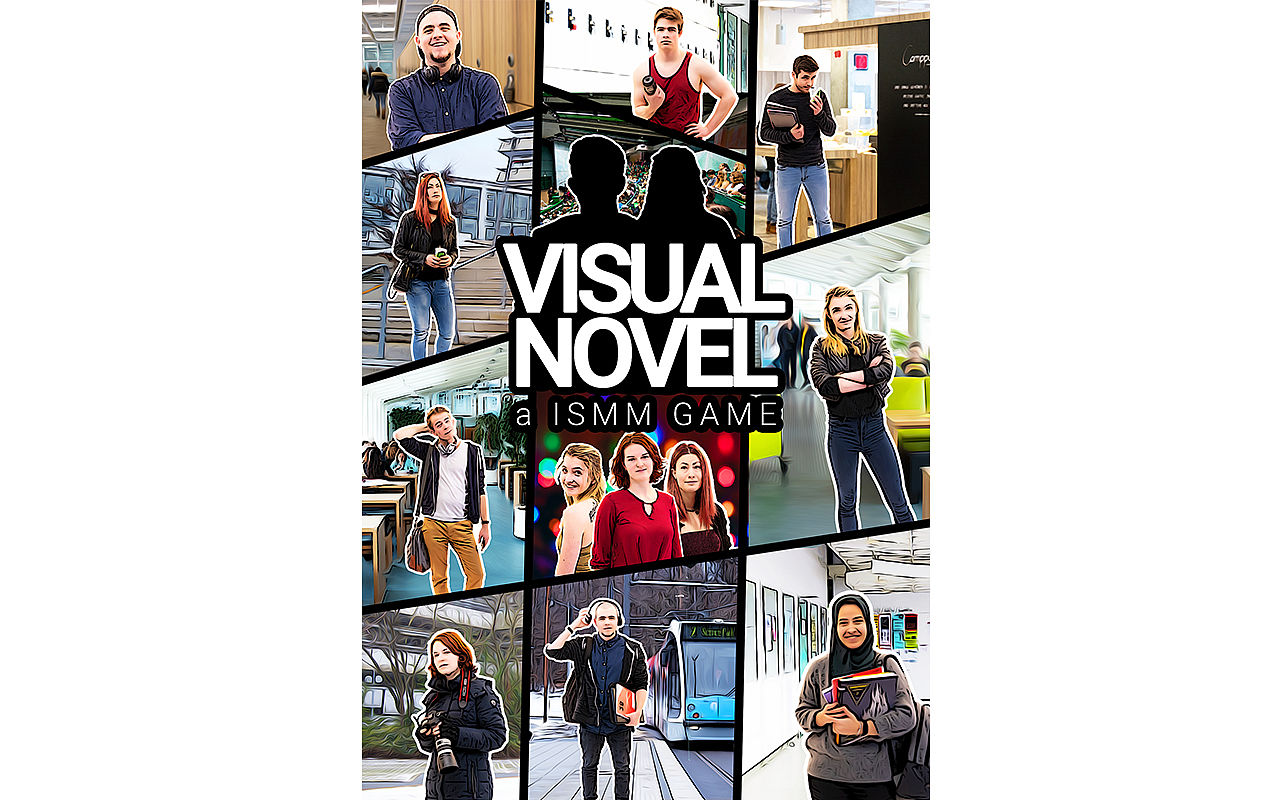

Visual-Novel (Talk / Demo)

Willkommen zur Visual Novel. Das erste Semester ist ein Sprung ins kalte Wasser. Familie und Freunde lassen wir unserer Heimat zurück und dann müssen wir uns auch noch mit Uni-stoff auseinandersetzen. Das kann schnell überwältigend werden! In Visual Novel bekommt ihr nochmal eine Chance das erste Semester zu erleben. Habt ihr eure Sozialen Kompetenzen schweifen lassen oder habt ihr nicht genug gelernt? Entscheidet euch in diesem Rerun anders und erforscht eine neue Dimension des Unilebens. In dieser Geschichte werdet ihr, je nachdem wie ihr euch entscheidet, bis zu neun verschiedene Charaktere kennen lernen. Freundet euch mit ihnen an und schaltet Bonuslevels frei in denen ihr sie besser kennen lernt. Vergesst aber auch nicht dass man an der Uni lernen muss, sonst fallt ihr durch die Klausuren durch!